Entre las imágenes de las casas bombardeadas y las calles devastadas de Gaza, algunas se destacaron por el horror absoluto: niños ensangrentados y abandonados.

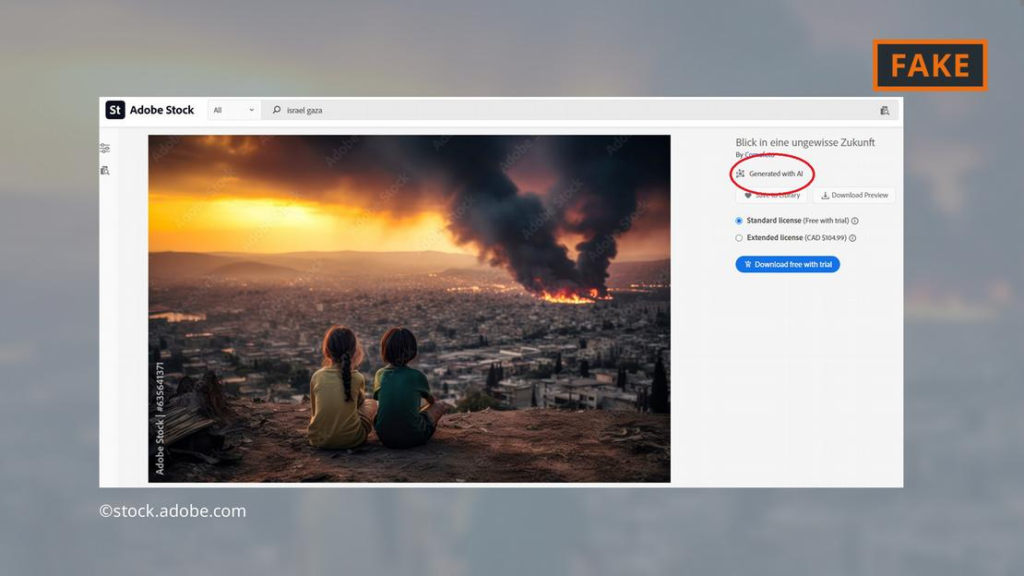

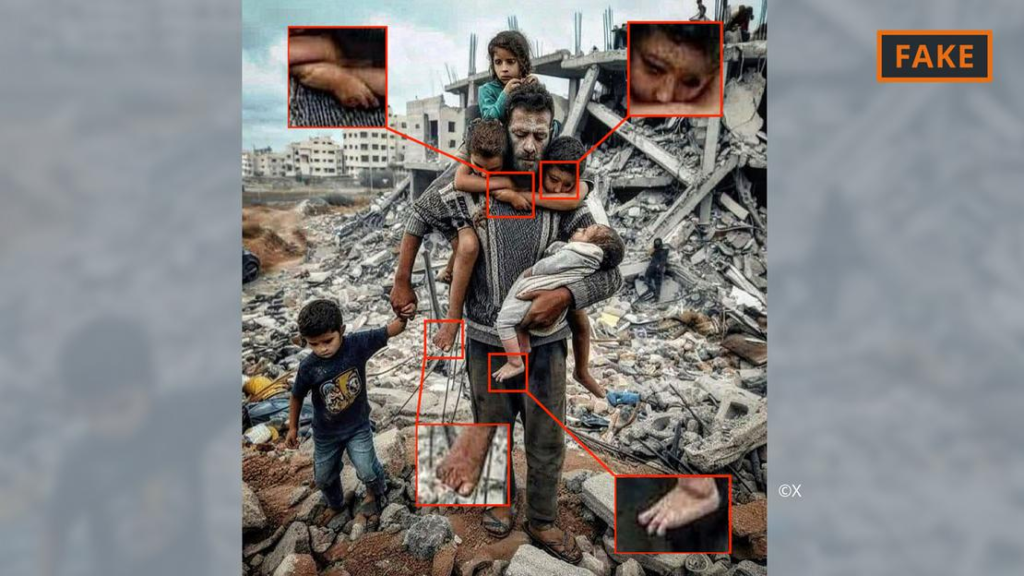

Estas imágenes, vistas millones de veces en línea desde que comenzó la guerra, son deepfakes creadas con inteligencia artificial. Si miras de cerca, puedes ver pistas: dedos que se curvan de manera extraña u ojos que brillan con una luz antinatural: todos ellos signos reveladores de engaño digital.

Sin embargo, la indignación que las imágenes fueron creadas para provocar es demasiado real.

Las imágenes de la guerra entre Israel y Hamas han ilustrado vívida y dolorosamente el potencial de la IA como herramienta de propaganda, utilizada para crear imágenes realistas de matanzas. Desde que comenzó la guerra el mes pasado, los archivos alterados digitalmente y difundidos en las redes sociales se han utilizado para hacer afirmaciones falsas sobre la responsabilidad de las víctimas o para engañar a la gente sobre atrocidades que nunca ocurrieron.

Si bien la mayoría de las afirmaciones falsas que circulan en línea sobre la guerra no requirieron inteligencia artificial para su creación y provienen de fuentes más convencionales, los avances tecnológicos se producen con una frecuencia cada vez mayor y poca supervisión. Esto ha hecho claramente evidente el potencial de la IA para convertirse en otra forma de arma y ha ofrecido un vistazo de lo que vendrá durante futuros conflictos, elecciones y otros grandes eventos.

«Va a empeorar, mucho peor, antes de mejorar», dijo Jean-Claude Goldenstein, director ejecutivo de CREOpoint, una empresa de tecnología con sede en San Francisco y París que utiliza inteligencia artificial para evaluar la validez de las reclamaciones en línea. La compañía ha creado una base de datos de los deepfakes más virales que han surgido en Gaza. «Imágenes, vídeo y audio: con la IA generativa será una escalada que no has visto».

En algunos casos, fotografías de otros conflictos o desastres se han reutilizado y se han hecho pasar por nuevas. En otros, se han utilizado programas de IA generativa para crear imágenes desde cero, como la de un bebé llorando en medio de los restos de un bombardeo que se volvió viral en los primeros días del conflicto.

Otros ejemplos de imágenes generadas por IA incluyen videos que muestran supuestos ataques con misiles israelíes, tanques avanzando por vecindarios en ruinas o familias buscando sobrevivientes entre los escombros.

En muchos casos, las falsificaciones parecen diseñadas para provocar una fuerte reacción emocional al incluir cuerpos de bebés, niños o familias. En los sangrientos primeros días de la guerra, los partidarios tanto de Israel como de Hamás alegaron que el otro lado había victimizado a niños y bebés; Las imágenes ultrafalsas de bebés llorando ofrecieron una «evidencia» fotográfica que rápidamente se presentó como prueba.

Los propagandistas que crean este tipo de imágenes son hábiles para atacar los impulsos y ansiedades más profundos de las personas, dijo Imran Ahmed, director ejecutivo del Centro para Contrarrestar el Odio Digital, una organización sin fines de lucro que ha rastreado la desinformación de la guerra. Ya sea un bebé falso o una imagen real de un bebé de otro conflicto, el impacto emocional en el espectador es el mismo.

Cuanto más aborrecible sea la imagen, más probabilidades habrá de que un usuario la recuerde y la comparta, propagando aún más la desinformación sin darse cuenta.

“Ahora mismo se le dice a la gente: miren esta foto de un bebé”, dijo Ahmed. «La desinformación está diseñada para que usted se comprometa con ella».

Contenido igualmente engañoso generado por IA comenzó a difundirse después de que Rusia invadió Ucrania en 2022. Un video alterado parecía mostrar al presidente ucraniano Volodymyr Zelenskyy ordenando a los ucranianos que se rindieran. Tales afirmaciones han seguido circulando hasta la semana pasada , lo que demuestra cuán persistente puede ser la información errónea, incluso fácilmente desacreditada.

Cada nuevo conflicto o temporada electoral ofrece nuevas oportunidades para que los traficantes de desinformación demuestren los últimos avances de la IA. Esto hace que muchos expertos en inteligencia artificial y politólogos adviertan sobre los riesgos el próximo año, cuando varios países celebren elecciones importantes, incluidos Estados Unidos, India, Pakistán, Ucrania, Taiwán, Indonesia y México.

El riesgo de que la IA y las redes sociales puedan utilizarse para difundir mentiras entre los votantes estadounidenses ha alarmado a los legisladores de ambos partidos en Washington. En una audiencia reciente sobre los peligros de la tecnología deepfake, el representante estadounidense Gerry Connolly, demócrata de Virginia, dijo que Estados Unidos debe invertir en financiar el desarrollo de herramientas de IA diseñadas para contrarrestar otras IA.

«Nosotros, como nación, debemos hacer esto bien», dijo Connolly.

En todo el mundo, varias empresas de tecnología emergentes están trabajando en nuevos programas que pueden detectar deepfakes , colocar marcas de agua en imágenes para demostrar su origen o escanear texto para verificar cualquier afirmación engañosa que pueda haber sido insertada por IA.

“La próxima ola de IA será: ¿Cómo podemos verificar el contenido que existe? ¿Cómo se puede detectar información errónea? ¿Cómo se puede analizar el texto para determinar si es confiable? dijo Maria Amelie, cofundadora de Factiverse, una empresa noruega que ha creado un programa de inteligencia artificial que puede escanear contenido en busca de imprecisiones o sesgos introducidos por otros programas de inteligencia artificial.

Estos programas serían de interés inmediato para educadores, periodistas , analistas financieros y otras personas interesadas en erradicar las falsedades, el plagio o el fraude. Se están diseñando programas similares para detectar fotografías o vídeos manipulados.

Si bien esta tecnología es prometedora, quienes utilizan la IA para mentir suelen ir un paso por delante, según David Doermann, un científico informático que dirigió un esfuerzo en la Agencia de Proyectos de Investigación Avanzada de Defensa para responder a las amenazas a la seguridad nacional que plantean las imágenes manipuladas por la IA.

Doermann, que ahora es profesor en la Universidad de Buffalo, dijo que responder eficazmente a los desafíos políticos y sociales que plantea la desinformación de la IA requerirá mejor tecnología y mejores regulaciones, estándares industriales voluntarios y grandes inversiones en programas de alfabetización digital para ayudar a los usuarios de Internet a comprender encontrar formas de distinguir la verdad de la fantasía.

«Cada vez que lanzamos una herramienta que detecta esto, nuestros adversarios pueden usar IA para ocultar ese rastro de evidencia», dijo Doermann. “Detectar y tratar de eliminar estas cosas ya no es la solución. Necesitamos tener una solución mucho mayor”.

AP/ David Kepler